Wahrnehmung für die Agrarrobotik*

I. Einführung

und die propriozeptive Wahrnehmung, die mit dem inneren Zustand des Roboters zusammenhängt (Ausrichtung, Geschwindigkeit, Beschleunigung usw.).

II. Die von Agrarrobotern verwendeten Sensoren

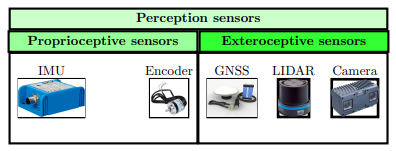

Wie in der Abbildung 1 unten dargestellten Abbildung gezeigt, können die von Agrarrobotern verwendeten Sensoren in zwei große Kategorien unterteilt werden: propriozeptive Sensoren, die den inneren Zustand des Roboters messen, und exterozeptive Sensoren, die die Elemente seiner Umgebung messen.

Abbildung 1: Von Agrarrobotern verwendete Sensoren

- Die inertiale Messeinheit (IMU: Inertial Motion Unit): Sie ist eine Einheit, die Informationen wie die lineare und die Winkelbeschleunigung des Roboters liefern kann.

- Die Encoder: Dies sind Sensoren, die die Radrotation messen.

Bei den exterozeptiven Sensoren finden sich insbesondere:

- Das GNSS (Global Navigation Satellite System), zum Beispiel ein GPS (Global Positioning System): Es verwendet Satellitensignale, um die Position des Roboters im Verhältnis zu einem festen Erdbezugssystem zu bestimmen. Seine Genauigkeit kann durch die Umgebung beeinträchtigt werden (z. B. durch die Überdachung). Unter normalen Bedingungen bietet es eine Genauigkeit im Meterbereich. Wenn es mit einer terrestrischen Referenzstation verbunden ist, wird die Genauigkeit zentimetergenau: Man spricht dann von GPS RTK (Real Time Kinematic).

- Die Kamera: Dieser Sensor liefert ein Bild der Umgebung des Roboters. Die RGB-D-Kameras (Red Green

- Blue - Distance) liefern sowohl ein Farbbild als auch die Entfernung der Objekte zum Roboter. Sie sind in der Landwirtschaft am weitesten verbreitet. Ihr Hauptnachteil bleibt ihre geringe Robustheit gegenüber störenden Elementen wie Regen, Schnee oder Staub, die das Objektiv verdecken können.

- Der LIDAR (Light Detection And Ranging): Im Gegensatz zur Kamera ist er robust gegenüber schlechten Wetterbedingungen und Staub. Durch das Senden und Empfangen von Lichtstrahlen erzeugt er eine Punktwolke, die die Umgebung um den Roboter darstellt, und ermöglicht so dessen Kartierung. Allerdings ist er etwa fünfmal teurer als eine Kamera.

III. Ansätze zur propriozeptiven Wahrnehmung

Um die Genauigkeit zu verbessern, kombiniert man die Informationen der Sensoren, was eine zuverlässigere Lokalisierung ermöglicht. Zu den am häufigsten verwendeten Algorithmen für diese Art der Fusion gehört der Kalman-Filter.

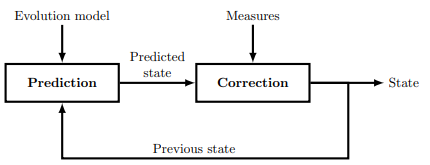

Abbildung 2: Prinzip eines Kalman-Filters

Es basiert auf zwei Hauptschritten. Der erste ist die Vorhersage, die den zukünftigen Zustand des Roboters aus seinem vorherigen Zustand und seinem Entwicklungsmodell schätzt. Der zweite ist die Korrektur, bei der die von den Sensoren erhaltenen Messungen verwendet werden, um die durchgeführte Vorhersage anzupassen und zu verfeinern, wodurch eine genauere Schätzung des tatsächlichen Zustands des Roboters ermöglicht wird.

- Vorhersage: Dieser Schritt verwendet den vorherigen Zustand des Roboters und das Entwicklungsmodell, um seinen zukünftigen Zustand vorherzusagen.

- Korrektur: In diesem Schritt wird der vorhergesagte Zustand mit den von den Sensoren erhaltenen Messungen verglichen und die Schätzung des Zustands angepasst, wodurch eine genauere Lokalisierung des Roboters ermöglicht wird.

IV. Ansätze zur exterozeptiven Wahrnehmung

Diese Algorithmen basieren auf den exterozeptiven Sensoren, die neben ihrem Beitrag zur propriozeptiven Wahrnehmung (wie im Fall der Lokalisierung durch GNSS RTK) zur Darstellung der Umgebung verwendet werden.

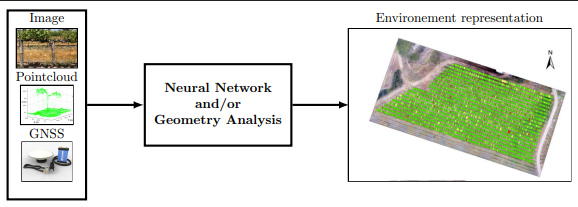

Wie in der Abbildung 3 unten gezeigten Abbildung hat die exterozeptive Wahrnehmung für einen Agrarroboter also die Hauptaufgabe, die Umgebung des Roboters zu modellieren und diesen in dieser Umgebung zu positionieren.

Abbildung 3: Prinzip der exterozeptiven Wahrnehmung

Verwendung von Ansätzen, die auf künstlicher Intelligenz oder geometrischer Analyse basieren, um die nützliche Umgebung des Roboters anhand von Bildern, Punktwolken und/oder seiner GNSS-Position zu modellieren.

- Ansatz basierend auf künstlicher Intelligenz: Ein neuronales Netzwerk analysiert die Informationen der Sensoren (Bilder, Punktwolken), identifiziert und klassifiziert die verschiedenen Elemente in der Umgebung (interessante Pflanzen, Unkräuter, Hindernisse, Menschen usw.) und erzeugt dann eine strukturierte Kartierung, die die Positionen jedes dieser Elemente sowie die des Roboters umfasst.

- Ansatz basierend auf geometrischer Analyse: Das Ergebnis ist ähnlich, nämlich eine Kartierung der verschiedenen Elemente der Umgebung und des Roboters. Der Unterschied liegt in der Methode: Sie basiert auf der geometrischen Analyse der von den Sensoren bereitgestellten Punktwolken. Zum Beispiel können bestimmte geometrische Formen in der Punktwolke erkannt und einer spezifischen Kategorie zugeordnet werden (interessante Pflanze, Unkraut usw.).

V. Fazit

Abschließend nutzt ein Agrarroboter propriozeptive und exterozeptive Sensoren, um seine Umgebung wahrzunehmen und sich präzise zu lokalisieren. Zu den am weitesten verbreiteten gehören das GNSS (GPS RTK), die RGB-D-Kamera und der LIDAR. In Kombination mit geeigneten Algorithmen liefern diese Sensoren dem Roboter entscheidende Informationen für die Navigation und autonome Entscheidungsfindung.

*: Die in diesem Artikel präsentierten technischen Informationen werden zu Informationszwecken bereitgestellt. Sie ersetzen nicht die offiziellen Anleitungen der Hersteller. Vor jeder Installation, Handhabung oder Nutzung konsultieren Sie bitte die Produktdokumentation und beachten Sie die Sicherheitsanweisungen. Die Website Torque.works kann nicht für eine unsachgemäße Verwendung oder eine falsche Interpretation der bereitgestellten Informationen verantwortlich gemacht werden.