Percepcja dla Robotyki Rolniczej*

I. Wprowadzenie

oraz percepcja proprioceptywna, związana z wewnętrznym stanem robota (orientacja, prędkość, przyspieszenie itp.).

II. Czujniki używane przez roboty rolnicze

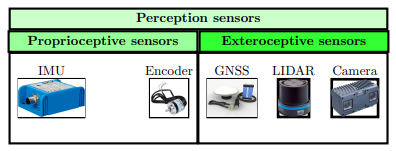

Jak przedstawia Rysunek 1 poniżej, czujniki używane przez roboty rolnicze można podzielić na dwie główne kategorie: czujniki proprioceptywne, które mierzą wewnętrzny stan robota, oraz czujniki eksteroceptywne, które mierzą elementy jego otoczenia.

Rysunek 1: Czujniki używane przez roboty rolnicze

- Jednostka inercyjna (IMU: Inertial Motion Unit): to jednostka zdolna do dostarczania informacji takich jak przyspieszenie liniowe i kątowe robota.

- Enkodery: to czujniki, które mierzą obrót kół.

Jeśli chodzi o czujniki eksteroceptywne, można wymienić:

- GNSS (Global Navigation Satellite System), na przykład GPS (Global Positioning System): wykorzystuje sygnały satelitarne do określenia pozycji robota względem stałego odniesienia na Ziemi. Jego dokładność może być wpływana przez środowisko (na przykład przez przesłonięcie przez baldachim). W normalnych warunkach oferuje dokładność rzędu metra. Gdy jest połączony z naziemną stacją referencyjną, dokładność staje się centymetrowa: mówimy wtedy o GPS RTK (Real Time Kinematic).

- Kamera: ten czujnik dostarcza obraz otoczenia robota. Kamery RGB-D (Red Green

- Blue - Distance) dostarczają zarówno obraz w kolorze, jak i odległość obiektów względem robota. Są najczęściej stosowane w rolnictwie. Ich główną wadą jest niska odporność na czynniki zakłócające, takie jak deszcz, śnieg czy kurz, które mogą zasłaniać obiektyw.

- LIDAR (Light Detection And Ranging): w przeciwieństwie do kamery, jest odporny na niekorzystne warunki pogodowe i kurz. Poprzez emisję i odbiór wiązek świetlnych generuje chmurę punktów reprezentującą otoczenie robota, co umożliwia jego mapowanie. Jednakże, jest około pięć razy droższy niż kamera.

III. Podejścia do percepcji proprioceptywnej

Aby poprawić dokładność, łączy się informacje z czujników, co pozwala uzyskać bardziej wiarygodną lokalizację. Wśród najczęściej używanych algorytmów do tego typu fuzji znajduje się filtr Kalmana.

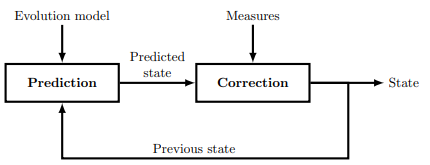

Rysunek 2: Zasada działania filtra Kalmana

Opiera się na dwóch głównych etapach. Pierwszym jest predykcja, która szacuje przyszły stan robota na podstawie jego poprzedniego stanu i modelu ewolucji. Drugim jest korekcja, podczas której pomiary z czujników są używane do dostosowania i udoskonalenia dokonanej predykcji, co pozwala uzyskać dokładniejsze oszacowanie rzeczywistego stanu robota.

- Predykcja: Ten etap wykorzystuje poprzedni stan robota i model ewolucji do przewidywania jego przyszłego stanu.

- Korekcja: Na tym etapie przewidywany stan jest porównywany z pomiarami uzyskanymi przez czujniki, a oszacowanie stanu jest dostosowywane, co pozwala uzyskać dokładniejszą lokalizację robota.

IV. Podejścia do percepcji eksteroceptywnej

Te algorytmy opierają się na czujnikach eksteroceptywnych, które, oprócz przyczyniania się do percepcji proprioceptywnej (jak w przypadku lokalizacji za pomocą GNSS RTK), są używane do reprezentacji środowiska.

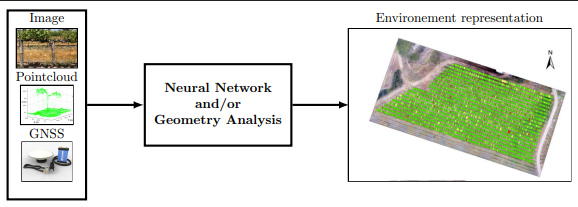

Jak pokazuje Rysunek 3 poniżej percepcja eksteroceptywna dla robota rolniczego ma więc główną rolę w modelowaniu środowiska robota i umieszczaniu go w tym środowisku.

Rysunek 3: Zasada percepcji eksteroceptywnej

Wykorzystanie podejść opartych na sztucznej inteligencji lub analizie geometrycznej do modelowania użytecznego środowiska robota na podstawie obrazów, chmur punktów i/lub jego pozycji GNSS.

- Podejście oparte na sztucznej inteligencji: sieć neuronowa analizuje informacje pochodzące z czujników (obrazy, chmury punktów), identyfikuje i klasyfikuje różne elementy obecne w środowisku (rośliny o znaczeniu, chwasty, przeszkody, ludzie itp.), a następnie generuje zorganizowaną mapę zawierającą pozycje każdego z tych elementów oraz robota.

- Podejście oparte na analizie geometrycznej: wynik jest podobny, czyli mapa różnych elementów środowiska i robota. Różnica polega na metodzie: opiera się na analizie geometrycznej chmur punktów dostarczanych przez czujniki. Na przykład, niektóre formy geometryczne w chmurze punktów mogą być wykrywane i przypisywane do określonej kategorii (roślina o znaczeniu, chwast itp.).

V. Wnioski

Podsumowując, robot rolniczy wykorzystuje czujniki proprioceptywne i eksteroceptywne do percepcji swojego otoczenia i precyzyjnej lokalizacji. Wśród najczęściej stosowanych znajdują się GNSS (GPS RTK), kamera RGB-D i LIDAR. Gdy są one połączone z odpowiednimi algorytmami, te czujniki dostarczają robotowi kluczowych informacji do nawigacji i podejmowania autonomicznych decyzji.

*: Informacje techniczne przedstawione w tym artykule są podane w celach informacyjnych. Nie zastępują one oficjalnych instrukcji producentów. Przed jakąkolwiek instalacją, obsługą lub użyciem, prosimy o zapoznanie się z dokumentacją produktu i przestrzeganie zasad bezpieczeństwa. Strona Torque.works nie ponosi odpowiedzialności za niewłaściwe użycie lub błędną interpretację dostarczonych informacji.